Hive的安装和配置

Hive的安装和配置

安装Hive

开启hadoop集群

将Hive压缩包解压到/root/bigdata目录下

tar -zxvf apache-hive-3.1.1-bin.tar.gz -C /root/bigdata/

配置Hive

进入到hive安装目录下的conf目录

root@master:~/bigdata/apache-hive-3.1.1-bin# cd /root/bigdata/apache-hive-3.1.1-bin/conf新建hite-site.xml文件

root@master:~/bigdata/apache-hive-3.1.1-bin/conf# vim hive-site.xml添加以下内容

<?xml version="1.0"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration> <property> <name>hive.metastore.local</name> <value>true</value> </property> <property> <name>javax.jdo.option.ConnectionUserName</name> <value>hadming</value> </property> <property> <name>javax.jdo.option.ConnectionPassword</name> <value>123456</value> </property> <property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://master:3306/hadoopDB?characterEncoding=UTF-8</value> </property> <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.jdbc.Driver</value> </property> </configuration>配置环境变量hive-env.sh

root@master:~/bigdata/apache-hive-3.1.1-bin/conf# cp hive-env.sh.template hive-env.sh root@master:~/bigdata/apache-hive-3.1.1-bin/conf# vim hive-env.sh将HADOOP_HOME路径添或修改如下:

HADOOP_HOME=/root/bigdata/hadoop-3.1.1使用生效:

root@master:~/bigdata/apache-hive-3.1.1-bin/conf# source hive-env.sh配置环境变量/etc/profile,加入HIVE的路径

root@master:~/bigdata/apache-hive-3.1.1-bin# vim /etc/profile添加如下代码:

# HIVE_HOME export HIVE_HOME=/root/bigdata/apache-hive-3.1.1-bin export PATH=$PATH:$HIVE_HOME/bin

使用生效:

root@master:~/bigdata/apache-hive-3.1.1-bin# source /etc/profile

配置hive-config.sh文件

root@master:~/bigdata/apache-hive-3.1.1-bin/bin# vim hive-config.sh在末尾添加以下代码:

export JAVA_HOME=/root/bigdata/jdk1.8.0_191 export HADOOP_HOME=/root/bigdata/hadoop-3.1.1 export HIVE_HOME=/root/bigdata/apache-hive-3.1.1-bin复制MySQL的驱动程序

创建目录source: root@master:~/bigdata# mkdir source将MySQL驱动程序解压至source目录下

root@master:~/downloads# dpkg -X mysql-connector-java_8.0.14-1ubuntu18.04_all.deb /root/bigdata/source切换目录并找到mysql-connector-java-8.0.14.jar文件(MySQL驱动),将其复制到HIVE安装文件的lib目录下。

root@master:~/downloads# cd /root/bigdata/source/usr/share/java root@master:~/bigdata/source/usr/share/java# cp mysql-connector-java-8.0.14.jar /root/bigdata/apache-hive-3.1.1-bin/lib/元数据初始化,进入到hive的bin目录下,执行schematool 命令

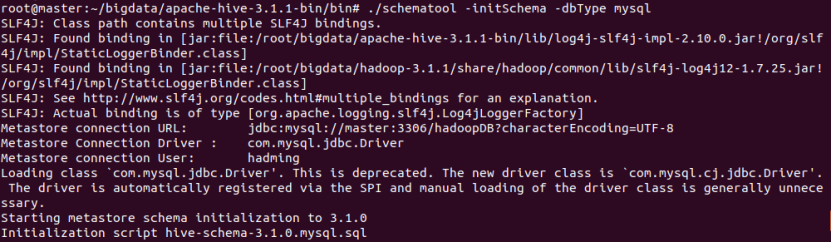

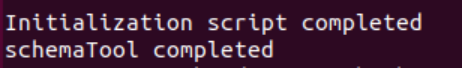

root@master:~/bigdata/apache-hive-3.1.1-bin/bin# ./schematool -initSchema -dbType mysql

启动Hive

root@master:~/bigdata/apache-hive-3.1.1-bin/bin# hive

注:第一次输入hive命令时我出现以下错误:(在机房没有这个错误)

打开环境变量文件,重新生效一下,就可以了

root@master:~/bigdata/apache-hive-3.1.1-bin/bin# vim /etc/profile root@master:~/bigdata/apache-hive-3.1.1-bin/bin# source /etc/profile

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 h3110w0r1d's Blog!